Sistemas de enseñanza/aprendizaje

Para obtener los resultados que queremos de un sistema, o evitar que genere eventos indeseables, necesitamos entender cómo funciona y se comporta en el mundo real. Eso es exactamente lo que hace el jidoka.

Los errores –llamémoslos eventos indeseables– suelen seguir el mismo patrón y su análisis suele identificar tres culpables obvios: una pieza o equipo defectuoso, una persona culpable que hace mal su trabajo debido a suposiciones erróneas o confusión, o información que se perdió, mal dirigida o simplemente equivocada. Los dos últimos acontecimientos adversos que presencié en un hospital fueron un problema cardíaco, no detectado porque el electrocardiógrafo no funcionaba correctamente, y un paciente psiquiátrico enviado a un pabellón psiquiátrico con una neumonía muy agravada porque su psiquiatra le recordaba sano como un caballo en su última visita tres meses antes y no pensó en comprobar si podría haber algo biológicamente malo en él. En ambos casos, la información estaba en el sistema pero no logró conectarse con los tomadores de decisiones.

Descubrir qué salió mal es cuestión de analizar pacientemente cada evento y detectar cuándo lo real se desvió de lo esperado: algo relativamente fácil de hacer en retrospectiva, pero extremadamente difícil de predecir porque es imposible saber de antemano qué variación tendrá qué efecto. Insistir en seguir cada procedimiento al pie de la letra suele atascar las cosas hasta que no pasa nada y cada paso requiere un tiempo y un dolor infinitos. Por otro lado, los procedimientos existen por una razón y nunca se sabe qué variación puede tener o tendrá efectos catastróficos.

Sin embargo, cuando uno pregunta por qué las cosas salieron mal, las respuestas son inmediatamente más turbias. Pocas personas cometen violaciones reales: hacen algo malo deliberadamente para su propio beneficio. La mayoría de las veces cometen errores, al igual que las piezas fallan con el uso y la información no se comunica correctamente. La búsqueda de respuestas a menudo conduce a la “cultura” o al “sistema”, ambos impulsados por líderes incompetentes, inmorales o negligentes que han ignorado repetidamente los llamados a trabajar más en materia de seguridad o han presionado tanto para lograr resultados que, comprensiblemente, las personas se han visto obligadas a hacerlo tomando atajos y... ¡zas! Estas explicaciones sistémicas son innegablemente ciertas en algunos casos y hay casos documentados de culturas nocivas que alientan a gerentes tóxicos e intimidan a las personas para que hagan lo incorrecto, pero lo incorrecto también sucede cuando la cultura no es particularmente mala ni está obsesionada con el desempeño. Las explicaciones a nivel cultural son fascinantes, pero poco útiles, ya que nadie sabe cómo cambiar las culturas excepto cambiar a los líderes –e incluso eso tiene efectos inesperados e incontrolados (la cultura se come la estrategia –y el liderazgo– en el desayuno, como dice el refrán).

¿Qué tipo de explicaciones “intermedias” podríamos construir para explicar el fracaso? Si dejamos de lado tanto la explicación de la “pieza rota, la persona incompetente” como la de la “cultura”, ¿cómo podríamos construir una justificación para los eventos adversos que evite ambos extremos?

Podemos reconocer que, en primer lugar, los sistemas tienen un aspecto mecanicista orientado a objetivos: en cualquier caso, están diseñados de esa manera. En segundo lugar, los procesos del sistema siempre se activan en contexto, en condiciones locales, que pueden variar desde “en control” (lejos del borde del acantilado) hasta “fuera de control” (a un paso del caos), y estas condiciones locales influirán significativamente afectan el funcionamiento del sistema. Finalmente, los humanos son agentes voluntarios: actúan por su propia voluntad, según sus luces, y eligen involucrarse o no, expresar o no sus intuiciones o sentimientos, actuar o no. Al observar cómo convergen estos tres factores, podemos dibujar una imagen diferente de cómo suceden las cosas.

Los sistemas humanos rara vez se comportan como fueron diseñados, pero de todos modos están diseñados. Una sala de urgencias está diseñada para procesar a los pacientes en términos de urgencia y tipo de patología. No está diseñada para gestionar grandes cambios de afluencia, al contrario que la caja de un supermercado, donde se pueden abrir o cerrar más cajas según el tamaño de las colas. Los sistemas tienen una dimensión de “proceso” mecanicista que les permite alcanzar uno o dos objetivos principales con una larga lista de limitaciones, como regulaciones, asignación presupuestaria y recursos disponibles. El sistema está destinado a manejar casos genéricos y satisfacer a su población de clientes en general; esto también significa que rara vez está concebido para cuidar de usted y sus circunstancias específicas. Al personal de urgencias poco le importará que usted tenga que coger un vuelo si su queja parece benigna (para ellos).

Los sistemas tienen una línea de base. Tienen metas y submetas. Han definido procesos y actividades para lograr estos objetivos. Tienen controles para garantizar que el desempeño, las regulaciones y los procesos se lleven a cabo de acuerdo con los estándares. Están diseñados para casos promedio en condiciones promedio, con procedimientos específicos para enfrentar circunstancias especiales (que rara vez hacen bien). Para entender cómo funciona el sistema, podemos empezar por delinear su punto de ajuste mecánico: lo que intentará lograr en cualquier circunstancia, ya sea apropiada o no.

En segundo lugar, los sistemas se activan en las condiciones locales. Aunque el sistema está diseñado para circunstancias normales, muy a menudo sucede en la vida real y las condiciones no son las esperadas. Las condiciones no pueden sistematizarse (e incluirse en la mecánica del sistema) precisamente porque varían. Es necesario confiar en la experiencia y el juicio humanos para descubrir las condiciones: ¿es un día normal o anormal? ¿Estaba el médico jefe de buen o de mal humor? ¿Está clara la situación o están sucediendo tantas cosas al mismo tiempo que todos están confundidos? ¿Existe un acceso rápido a expertos que comprendan estas condiciones o se deja que las personas tomen decisiones por sí mismas? ¿Existe una cultura de altas o bajas expectativas? Y así sucesivamente, las preguntas pueden ser infinitas. Las condiciones locales se traducirán, en primer lugar, en fricción: dificultades para lograr el paso del proceso debido a la ambigüedad, el azar, la incertidumbre o la simple entropía y todos los comodines que el mundo real puede arrojar a un proceso. La fricción es la clave para comprender las condiciones locales en lugar de tener ideas a priori, porque la fricción es reconocible y es posible preguntar qué condición crea esta fricción.

A nivel local, la fricción puede conducir a una reutilización: las personas adaptan el sistema a las condiciones locales para su propio uso. El mantenimiento del mismo tipo de equipo, por ejemplo, puede variar ampliamente según las condiciones locales: cómo de lejos están del fabricante y cómo de fácil es obtener asesoramiento experto y capacitación local, cómo de dispuesto está el gerente local a gastar el presupuesto de mantenimiento en mantenimiento o lo está usando para otra cosa, etc. La reutilización del sistema es una adaptación a las condiciones locales donde la gente cambia los objetivos sólo para sobrevivir.

La reutilización suele ser gradual: no ocurre de golpe, sino más bien a un ritmo lento, a medida que las personas son derrotadas por las condiciones locales y progresivamente aceptan las condiciones anormales como normales. La habituación es una fuerza motriz en el ser humano y la gente básicamente se acostumbrará a todo y dejará de excitarse por situaciones que saben que deberían ser intolerables, pero que se han convertido en rutinarias. Comenzando con la fricción y conduciendo a la reutilización, las condiciones locales son el segundo elemento que puede ayudar a comprender el comportamiento del sistema, si las examinamos con suficiente atención (y con la mente suficientemente abierta).

En tercer lugar, las personas tienen acciones intencionales: intervendrán voluntariamente o, por el contrario, decidirán voluntariamente no hacerlo. El silencio o la violencia son reacciones típicas al conflicto y la frustración, y se puede esperar que las personas reaccionen de manera muy diferente ante las mismas situaciones. "No enviar mensajes de texto mientras se conduce" es una regla simple y obvia en términos de seguridad, y sin embargo, las personas lo interpretarán de manera muy diferente según cómo se ven a sí mismos, su identidad o el sentido de su propio carácter, según su enfoque. en el lugar y la lógica de la situación ante sus ojos (tramo largo de carretera, tráfico lento, etc.) y también según su estado emocional, ya sea que estén concentrados en conducir, aburridos como locos o enloquecidos por un problema urgente que debe resolverse ahora mismo, por ejemplo.

Somos, por naturaleza, criaturas de sentimientos encontrados. Lo que queremos cambia de un momento a otro. Lo que pensamos sobre una situación por la mañana puede cambiar por la noche. No es casualidad que la mayoría de las filosofías antiguas busquen formas de encontrar algún tipo de paz: nuestras mentes simplemente no están preparadas para ello. En nuestro mundo actual de máquinas y sistemas, a menudo tratamos a las personas como si fueran máquinas, siguiendo instrucciones y procesos establecidos como robots, pero eso requiere una presión extrema; simplemente no es así como la gente piensa y se comporta. No existe una única forma de describir la complejidad del comportamiento humano, la motivación y la toma de decisiones, pero a falta de un sistema mejor, todavía a menudo lo descomponemos en los tres antiguos componentes de pathos, logos y ethos:

- Pathos: ¿cómo de excitada emocionalmente está la persona? ¿Están tranquilos y razonan las cosas, sopesan argumentos y consideran perspectivas? ¿O son emocionales y reducen la situación a lo que necesitan hacer ahora mismo, impulsiva e instintivamente, impulsados por su estado de ánimo y su experiencia subjetiva del momento? Una misma persona reaccionará de forma muy diferente según su estado emocional (sentirse bien/sentirse mal) y lo intenso que sea (sentirse tranquilo/estar emocional).

- Logos: ¿cómo de sólida es su lógica? Según su comprensión de la situación (y cuán fuertes sean sus emociones e intuiciones), las personas pueden hacer análisis lógicos de causa y efecto, donde su comportamiento conducirá lógicamente hacia una meta deseada basada en hechos, o afirmaciones descabelladas y saltos intuitivos "saludos Mary” basados en suposiciones inestables.

- Ethos: ¿Cómo de responsables y dignos de confianza son en general? Se puede depender de algunas personas más que de otras para aceptar la responsabilidad y hacer lo mejor para el grupo, fomentando la cooperación y el apoyo mutuo en lugar de decepcionar a los demás haciendo lo mejor para ellos en el momento: actuar de manera impulsiva o negligente y no completar tareas o asignaciones según lo prometido y luego culpar a otros por sus deficiencias. ¿Se puede confiar normalmente en esta persona, o no?

Con estos tres factores coyunturales en mente, ahora podemos ir más allá del análisis de incidentes de “pieza mala, error humano, información incorrecta” y mirar más profundamente: 1) ¿A qué distancia de su línea base se comportó el sistema? 2) ¿Cuáles fueron las condiciones locales específicas? Y 3) ¿Quiénes eran las personas presentes y cómo reaccionaron? ¿Eligieron intervenir o no? ¿Sus intervenciones tuvieron sentido o no?

Si lo miramos de esta manera, podemos ver que un cuarto elemento marca una diferencia crítica en el resultado: ¿hasta qué punto entendió la gente cómo funciona el sistema? El conocimiento del sistema sobre cuál es su punto de partida y cómo reacciona en diferentes condiciones tendrá un gran impacto tanto en la emocionalidad de la situación como en la lógica de las respuestas. Si las personas saben lo que hace el sistema, es más probable que se sientan capaces de intervenir y hacerlo con sensatez para evitar (o mitigar) un accidente.

En la mayoría de los incidentes hospitalarios que veo, los médicos y enfermeras a menudo no saben cómo funcionan los sistemas informáticos y administrativos, y cuando deciden intervenir, recurren a una solución que puede empeorar las cosas o, por el contrario, ignoran algo que debería estar hecho. En un hospital medio, las enfermeras rara vez aíslan el equipo a la primera señal de un problema y buscan agresivamente una solución de mantenimiento a través del sistema. Están tan abrumados con las tareas y saben que cualquier acción de mantenimiento probablemente lleve mucho tiempo, por lo que seguirán utilizando el equipo hasta que falle por completo, lo que añade incertidumbre y riesgo a medida que lo hacen. Por lo general, tienen modelos mentales muy vagos sobre cuán pronunciado se degrada el equipo (o qué tan grave es el impacto en el paciente de pequeños desajustes en las mediciones) y qué se necesita para reparar o reemplazar el equipo.

Las teorías erróneas sobre cómo funcionan las cosas conducen a reacciones ilógicas y más emocionales, ya que las personas se sienten más amenazadas por la situación y reaccionan de manera más intuitiva, un camino común hacia los efectos adversos. Lo que la gente sabe sobre los sistemas que utiliza tiene un impacto significativo en los resultados en el momento en que el sistema ya no se encuentra en sus condiciones básicas.

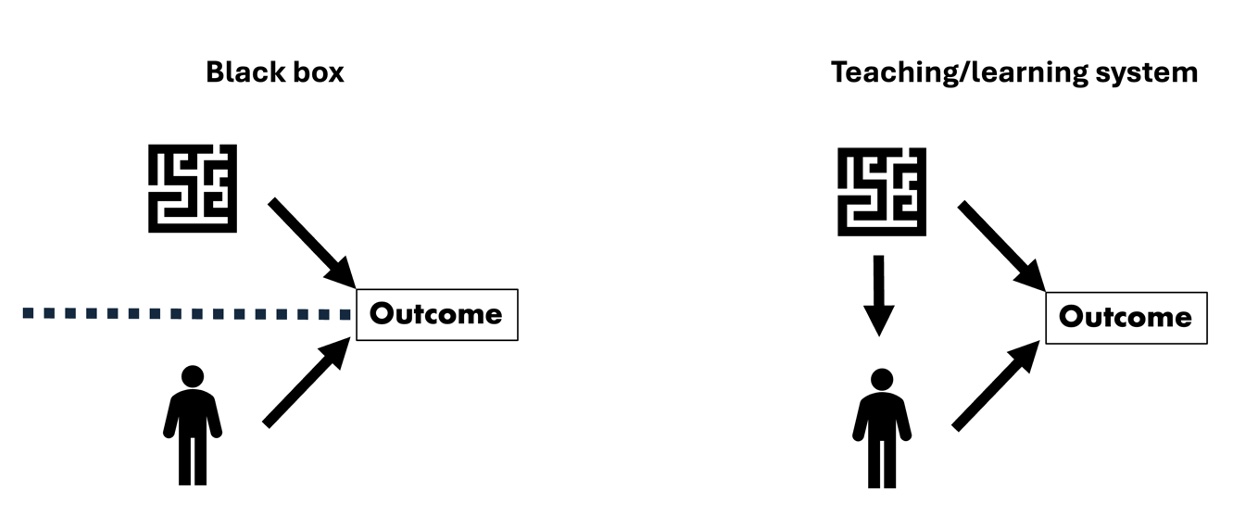

En consecuencia, los sistemas pueden diseñarse de dos maneras: ya sea como una caja negra donde el usuario no tiene forma de entender cómo funciona el sistema (los sistemas más complejos hoy en día) o como dispositivos de enseñanza donde el usuario puede mirar el sistema para entenderlo como funciona. lo usan. Hemos visto a los automóviles pasar de sistemas de enseñanza, donde los propietarios podían arreglar cosas básicas en sus automóviles, a cajas cada vez más negras fabricadas para mantener al conductor –y de hecho, en gran medida, al mecánico– fuera del motor.

Las cajas negras son atractivas para los diseñadores de sistemas porque sienten (con razón, sin duda) que cuantas menos personas modifiquen el sistema, mayores serán las posibilidades de que logre su comportamiento básico. La suposición aquí es usar el sistema hasta que se rompa y luego llamar a mantenimiento o reemplazarlo. Sin embargo, esta suposición no tiene en cuenta todos los estados intermedios en los que se encuentran los usuarios cuando el sistema no está en condiciones básicas ni se ha roto catastróficamente todavía, exactamente donde la acción puede evitar el desastre si sólo los usuarios supieran qué acciones tomar.

Los sistemas jidoka, con dispositivos como andon, están diseñados para educar a los usuarios. Desde el telar automático original de Sakichi, que se detenía cuando se rompía un hilo del algodón, hasta las fábricas actuales impulsadas por andon, estos sistemas están diseñados para detectar su propia anomalía, detener y llamar a un usuario para que pueda investigar y reemplazar el componente defectuoso. (o volver a capacitar al operativo). Al hacerlo, dichos sistemas enseñan a los usuarios sobre sí mismos y cómo trabajan para construir una imagen mental más precisa tanto de la línea base como, a través de la experiencia, de cómo se comporta el sistema en diferentes condiciones externas.

A medida que los sistemas se vuelven más complejos y sofisticados con tecnología cada vez más nueva, los diseñadores de sistemas deben plantearse una pregunta adicional: ¿cuánto deben aprender los usuarios sobre el sistema? Muchos gerentes ahora son parte y están a cargo de sistemas increíblemente complejos que han sido diseñados como cajas negras. Los gerentes ahora están capacitados para seguir procesos, no para comprender los comportamientos del sistema y, específicamente, no los comportamientos de su sistema. Como resultado, aunque los sistemas se vuelven más sofisticados, los resultados son cuestionables en todas partes y, ciertamente, la sensación de agencia y control humanos está disminuyendo rápidamente.

El jidoka de Lean tiene más que enseñar al mundo que simplemente unos pocos dispositivos a prueba de errores o formas inteligentes de detectar problemas antes de que ocurran. Originalmente se trataba de dotar a las máquinas de algunos aspectos de la inteligencia humana, es decir, reconocer una parte buena de una mala o un componente usado de un componente válido. Pero al hacerlo, jidoka (detectar cada defecto, notificar cada defecto, reaccionar inmediatamente y corregir la situación) también cambia la relación humana con los sistemas: crea sistemas de enseñanza/aprendizaje donde las personas pueden comprender mejor cómo funciona y se comporta el sistema en el mundo. mundo real y qué hacer al respecto para obtener los resultados que buscan. En cada sistema complejo como un hospital o una planta donde el comportamiento intencional afecta la seguridad, necesitamos saber más sobre cómo funciona el sistema, no menos, para hacerlo más seguro.

Michael BalléProfesional de Lean Management, escritor y autor de numerosos libros. Extraído de: Planet Lean